Если вы видели рекламу «МегаФона» с Брюсом Уиллисом — вы сталкивались с дипфейком. Актер дал компании Deepcake право на использование своего изображения после того, как в 2022 году у него диагностировали афазию и он больше не мог сниматься самостоятельно. Разберемся, что такое технология deepfake, где применяется и чем опасна.

Что значит дипфейк простыми словами

Дипфейк (от английского Deepfake) — это технология создания поддельных изображений, видео- и аудиоматериалов при помощи искусственного интеллекта. Контент генерируется на основе реальных материалов — записей голоса, фотографий и пр.

Происхождение названия «дипфейк» не самое приятное — в конце 2017 года на платформе Reddit человек под ником deepfakes загрузил видеоматериалы порнографического содержания, где лица заменили на лица звезд, без их согласия. История вызвала большой резонанс, и дипфейками стали называть все материалы, где искусственный интеллект заменяет внешность или речь.

Как работает технология дипфейк

Когда deepfake-технологии только появились, процесс их создания отличался сложностью и многоступенчатостью. Специалист должен был не только хорошо понимать принципы работы нейросетей, но и разбираться в необходимых вычислительных процессах. Также нужно было часто вносить изменения и обучать нейросеть под каждую конкретную задачу.

Сейчас создать дипфейк может даже школьник. На рынке существует большое количество готовых платформ и чат-ботов, способных создать дипфейки за несколько секунд. Все, что нужно сделать пользователю, — загрузить исходники (фотографии, видео, звуковые дорожки), остальное нейросеть сделает самостоятельно.

HeyGen — это одна из наиболее популярных платформ для создания дипфейков. С ее помощью вы можете за пару минут превратить текст в видео — для этого загружаете фотографию и короткое аудио, и на выходе получаете ожившую фотографию, которая разговаривает необходимым голосом. В легальных целях эту платформу используют для производства цифровых аватаров.

Где применяются дипфейки

Легально дипфейки активно применяют в создании образовательного контента. Так, для записи примитивного обучающего видео не нужно закладывать затраты на аренду студии и услуги монтажеров и звукооператоров — достаточно просто «скормить» искусственному интеллекту фотографию лектора, образец голоса и необходимый текст. Искусственный интеллект сгенерирует требуемый контент самостоятельно.

Технологию дипфейков активно применяют в музеях, галереях и арт- пространствах для создания дополненной реальности. Еще в 2019 году Музей Дали в США «оживил» художника к его 115-летнему юбилею. Нейросеть изучала мимику и детали лица Дали на основе более 6 000 кадров, а записи интервью и цитаты художника позволили сымитировать его уникальный акцент. Затем полученные данные наложили на актера со схожей мимикой и строением тела. Так посетители выставки смогли послушать рассказ о жизни Сальвадора Дали из уст самого художника, а также сделать с ним селфи.

Дипфейки помогают расширить границы развлекательного контента. Огромной популярностью пользуются видео, где в сценах известных кинолент с помощью искусственного интеллекта лица одних актеров накладывают на другие. Так, ролик ютубера EZRyderX47, где он заменил лица главных актеров культового фильма «Назад в будущее» на Тома Холланда и Роберта Дауни-младшего, собрал более 11 миллионов просмотров. Тематика «что если их бы сыграли» — одна из наиболее популярных в создании развлекательного дипфейк-контента. В TikTok также популярны дипфейк-ролики с персонажами «Гарри Поттера»: любимые герои дефилируют на показах модных домов, переносятся в другие вселенные и эпохи, играют в сценах из фанфикшена.

Использование дипфейков в киноиндустрии остается спорным вопросом. С их помощью можно заменить актеров, которые ушли из жизни во время съемок, например, как это произошло с Филипом Сеймуром из «Голодных игр». Часто дипфейки используют во франшизе «Звездных войн», чтобы воссоздать молодые образы персонажей при съемках приквелов. Это вызывает споры среди фанатов, так как, хоть такой подход и позволяет видеть на экране точные копии любимых персонажей, это лишает реальных новых актеров возможности сыграть героев.

Недавно интернет взорвала новость о попытках компании Particle6 продвигать Тилли Норвуд — сгенерированную их нейросетью «актрису». Компания считает, что фейковая актриса сможет стать «новой Скарлетт Йоханссон», ожидает контрактов с агентствами талантов и уже выпустила сгенерированный комедийный скетч, написанный чатом GPT, с Тилли в главной роли. Но эту идею раскритиковали, увидев в образе дипфейка черты многих известных голливудских актрис, ни одна из которых не давала согласия на использование ее изображения в подобных целях. Сами голливудские актрисы осудили инициативу за неэтичность, так как сгенерированная актриса не сможет отказаться от съемок, работает круглосуточно и не требует оплаты, в отличие от реальных женщин. «Гильдия киноактеров США — Американская федерация телевизионных и радио артистов» (SAG-AFTRA) призвала бойкотировать любые агентства, которые подпишут контракт с дипфейком, а также официально заявила, что не считает Норвуд актрисой в принципе.

Чем опасны дипфейки

Главная опасность дипфейков в том, что их никак не регулируют. Так, на момент написания статьи (октябрь 2025 года) только Дания ввела всеобъемлющий закон против дипфейков, по которому каждому гражданину страны даровано право на его цифровую идентичность. Это позволяет по закону требовать полного удаления несанкционированных дипфейков, а также получать компенсации за нанесенный ущерб. Такие страны, как Великобритания и Южная Корея криминализировали создание и распространение порнографических дипфейков, а также тех, которые нарушают права человека. В России законодательная база о дипфейках находится только на стадии разработки.

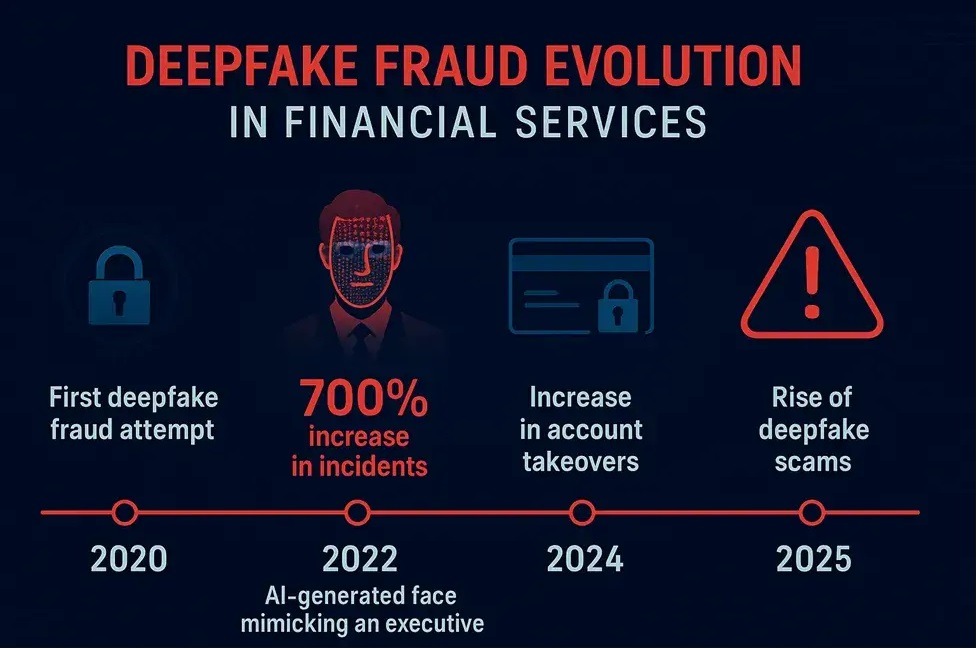

Дипфейками активно пользуются мошенники. Всем известны истории о звонках якобы близких людей, которые попали в беду и просят перевести им деньги. Сейчас технологии позволяют совершать подобные действия через видеозвонки. И если все больше людей уже научились распознавать обычные звонки мошенников, то видеозвонки от копии лучшего друга способны ввести в заблуждение даже самых бдительных пользователей. Известны случаи, когда директор английской компании перевела мошенникам 243 тысячи долларов после звонка от якобы своего руководителя, а китайский бизнесмен после звонка дипфейка своего друга потерял 610 тысяч долларов.

Еще один способ мошеннического обогащения — это рекламные ролики, в которых используют дипфейки известных лиц. Например, от лица Олега Тинькова (признан Минюстом иноагентом) мошенники призывали клиентов инвестировать и получать бонусы, переходя по прикрепленной ссылке, которая вела на фейковый сайт, стилизованный под «Т-Инвестиции».

Также с помощью дипфейков можно создать компрометирующие материалы и шантажировать ими жертву. Это могут быть как сгенерированные видео с получением взятки или совершением других противоправных действий, так и огромный спектр порномести, особенно часто встречающийся при расставаниях.

Как создать дипфейк

При создании дипфейка используют алгоритмы глубокого обучения — генеративно-состязательные сети, или GAN. Они состоят из двух нейросетей: генеративная создает изображения, а состязательная — «соревнуется» с ней (отсюда и название), пытаясь отличить правильные черты дипфейка (похожие на заданного человека) от неправильных. Задача генеративной нейросети — добиться того, чтобы состязательная не смогла отличить сгенерированное изображение от оригинала.

Пошагово этот процесс выглядит следующим образом:

Собрать данные: чем больше информации вы предоставите алгоритмам, тем более реалистичный результат получите.

Обработать данные и обучить нейросеть — алгоритмы выделяют ключевые характеристики лица модели и передают их нейросети. Та учится собирать изображения этого лица, постоянно сравнивая получившийся результат с оригиналом, пока не перестанет отличать один от другого,

Сгенерировать необходимый дипфейк — автор применяет обученную нейросеть на целевое видео, где она заменяет исходное лицо на сгенерированную модель.

Сделать финальную обработку — часто полученный дипфейк нуждается в ретуши и других доработках, чтобы добиться максимальной реалистичности.

На заре дипфейк-технологий авторам такого контента необходимо было досконально разбираться в работе нейросетей, чтобы оптимизировать их процессы и получить необходимый результат. Но сейчас на потребительском уровне этот процесс упрощен и автоматизирован, пользователям достаточно поставить задачу и загрузить в нейросеть оригиналы. Остальное программы выполняют без человеческого участия.

Reface — одно из наиболее популярных приложений для создания простых дипфейков. Загрузив свою фотографию, пользователи могут пообниматься с Джеком на носу Титаника, «оживить» произведения искусства и переозвучить любое видео. Приложение предлагает качественный уровень контента на выходе, без «шумов» на лице и сползающих масок.

Приложение FaceApp использует технологии дипфейков в другом ключе — оно позволяет пользователям редактировать фотографии на уровне профессионального фотошопа. Можно примерить на себя различные виды причесок, избавиться от несовершенств на коже и даже провести фейковые пластические операции, полностью перекроив свое лицо.

Как распознать дипфейк

Самый простой метод — довериться критическому мышлению. Если люди на видео слишком идеальны, неестественно двигаются, редко моргают, говорят монотонно и в принципе вызывают у вас эффект зловещей долины — психологическое явление, при котором искусственный объект, крайне похожий на человека, вызывает у наблюдателя тревогу и неприязнь, — скорее всего перед вами дипфейк. Также стоит обратить внимание на тон кожи (совпадает ли он на лице и теле), детализацию различных частей изображения, перепады в освещении и пр.

Однако как и все ИИ-технологии, дипфейки быстро эволюционируют. Раньше сгенерированные изображения регулярно попадались на лишних пальцах или восковой коже, но сейчас невооруженным глазом подделку отличить становится все сложнее. На помощь приходят специальные программы для распознавания дипфейков. Они сканируют и анализируют изображения на более глубоком уровне, что позволяет им заметить мельчайшие искажения, неизменно возникающие в процессе манипуляций с изображением. Лучше всего они справляются с фото- и видеоконтентом.

Среди таких программ:

Forensically — сервис с простым и понятным набором бесплатных инструментов для анализа изображений;

Image Edited — еще одна бесплатная программа, которая изучает изменения в фотографиях на уровне пикселей и их цветов;

Ghiro — проводит криминалистический анализ огромного количества изображений автоматически;

Microsoft Video Authenticator — определяет вероятность присутствия монтажа.

Аудиальные дипфейки проще создавать — все, что необходимо для их генерации, это запись нужного голоса, — но гораздо сложнее распознать. Сегодня ученые предлагают опираться на методы, которые оценивают влияние анатомических особенностей голосового аппарата человека на речь — часто аудиодипфейки включают в себя звуки, которые человеческая гортань не способна издавать физиологически.

Постоянное совершенствование дипфейк-технологий делает работу кибербезопасников все более важной, так как теперь им необходимо не только защищать данные от прямых атак, но и изобретать способы защиты от «этических» взломов. Вместе с ProductStar вы можете освоить профессию инженера по информационной безопасности всего за год, и, кто знает, возможно именно вы поможете создать надежные средства распознавания дипфейков и защиты от мошеннических действий.

Как использовать дипфейки легально и безопасно

Как уже говорили выше, в мире мало законов, которые способны контролировать сферу создания дипфейков. Так что фактически легальность их использования сводится к двум правилам:

не используйте дипфейки для совершения мошеннических и противоправных действий;

если цель создания дипфейка коммерческая — вам необходимо получить разрешение на использование образа человека у него самого.

В целом, создание дипфейков ради развлекательного контента никак не регулируется и остается на совести автора. При условии, что это не принесло негативных последствий людям, чьи лица использовали.